不用纠结各类技术,大数据处理就这四步、并不难!

72

72

今天晚上在跟彭老师学大数据。快速做了个学习总结。

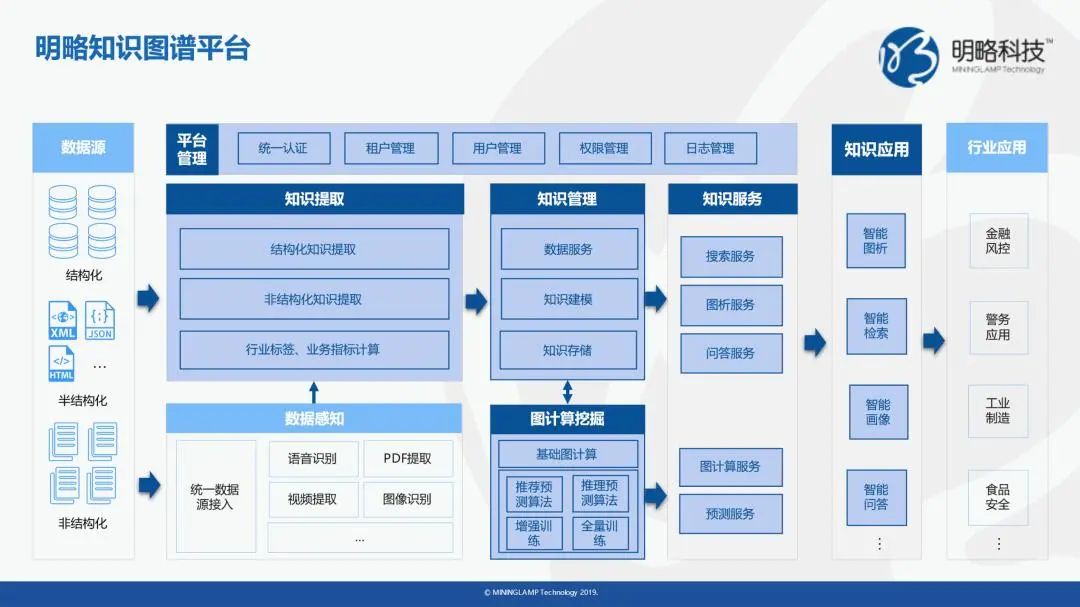

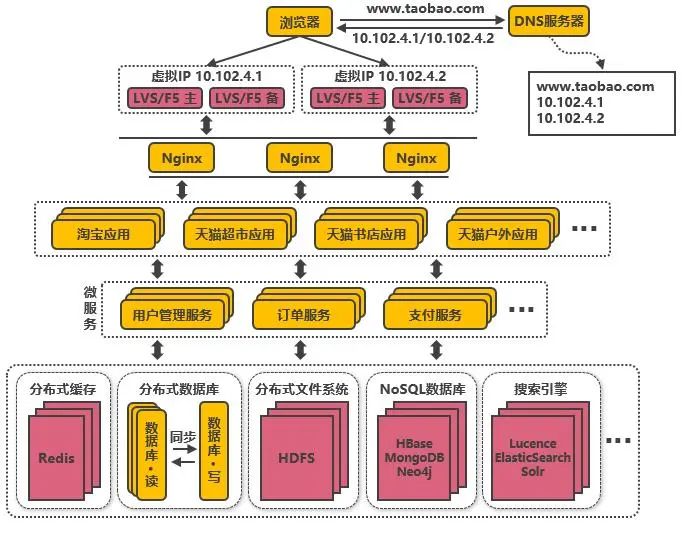

整个大数据的处理流程可以定义为:在合适工具的辅助下,对广泛异构的数据源进行抽取和集成,将结果按照一定的标准进行统一存储,然后利用合适的数据分析技术对存储的数据进行分析,从中提取有益的知识,并利用恰当的方式将结果展现给终端用户。

So,我们看到所谓大数据分析并不神秘,基础规则就是咱大学读的统计分析。如果你还想吃大数据的饭,那是不是有些后悔大学没好好上课,哈哈

参考文献来源公众号:编程帮

思路借鉴:彭文华

笔记编辑:球迷Long

总结来说:

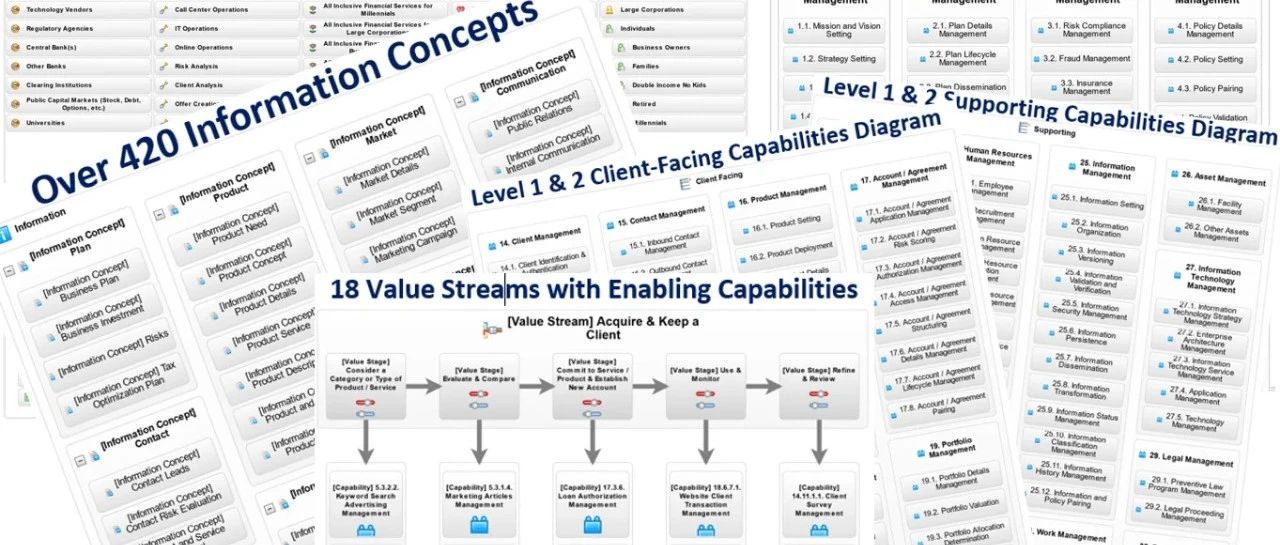

大数据处理的基本流程可以分为

数据抽取与集成、数据分析、数据解释、数据应用等步骤。

数据抽取与集成

从数据集成模型来看,现有的数据抽取与集成方式可以大致分为 4 种类型:

基于物化或 ETL 方法的引擎

基于联邦数据库或中间件方法的引擎

基于数据流方法的引擎

基于搜索引擎的方法

数据分析

数据分析是整个大数据处理流程的核心,大数据的价值产生于分析过程。

从异构数据源抽取和集成的数据构成了数据分析的原始数据。

根据不同应用的需求可以从这些数据中选择全部或部分进行分析。

小数据时代的分析技术,如统计分析、数据挖掘和机器学习等,并不能适应大数据时代数据分析的需求,必须做出调整。

大数据时代的数据分析技术面临着一些新的挑战,主要有以下几点。

1)数据量大并不一定意味着数据价值的增加,相反这往往意味着数据噪音的增多。

因此,在数据分析之前必须进行数据清洗等预处理工作,但是预处理如此大量的数据,对于计算资源和处理算法来讲都是非常严峻的考验。

2)大数据时代的算法需要进行调整。

首先,大数据的应用常常具有实时性的特点,算法的准确率不再是大数据应用的最主要指标。

在很多场景中,算法需要在处理的实时性和准确率之间取得一个平衡。

其次,分布式并发计算系统是进行大数据处理的有力工具,这就要求很多算法必须做出调整以适应分布式并发的计算框架,算法需要变得具有可扩展性。

许多传统的数据挖掘算法都是线性执行的,面对海量的数据很难在合理的时间内获取所需的结果。因此需要重新把这些算法实现成可以并发执行的算法,以便完成对大数据的处理。

最后,在选择算法处理大数据时必须谨慎,当数据量增长到一定规模以后,可以从小量数据中挖掘出有效信息的算法并一定适用于大数据。

3)数据结果的衡量标准。

大数据时代的数据量大,类型混杂,产生速度快,进行分析的时候往往对整个数据的分布特点掌握得不太清楚,从而会导致在设计衡量的方法和指标的时候遇到许多困难。

数据解释

数据解释的方法很多,比较传统的解释方式就是以文本形式输出结果或者直接在电脑终端上显示结果。这些方法在面对小数据量时是一种可行的选择。

解释大数据分析结果时,可以考虑从以下两个方面提升数据解释能力。

1)引入可视化技术。

可视化作为解释大量数据最有效的手段之一率先被科学与工程计算领域采用。

该方法通过将分析结果以可视化的方式向用户展示,可以使用户更易理解和接受。

常见的可视化技术有标签云、历史流、空间信息流等。

2)让用户能够在一定程度上了解和参与具体的分析过程。

这方面既可以采用人机交互技术,利用交互式的数据分析过程来引导用户逐步地进行分析,使得用户在得到结果的同时更好地理解分析结果的过程,也可以采用数据溯源技术追溯整个数据分析的过程,帮助用户理解结果。

数据应用

数据沟通能力。深入浅出的数据报告、言简意赅的数据结论更利于业务理解和接受,打比方、举例子都是非常实用的技巧。

业务推动能力。在业务理解数据的基础上,推动业务落地实现数据建议。从业务最重要、最紧急、最能产生效果的环节开始是个好方法,同时要考虑到业务落地的客观环境,即好的数据结论需要具备客观落地条件。

项目工作能力。数据项目工作是循序渐进的过程,无论是一个数据分析项目还是数据产品项目,都需要数据分析师具备计划、领导、组织、控制的项目工作能力。

--------------

※ 点赞+在看+转发的转型都能成功!

— 热门推荐阅读 —

⊕ 城市大脑数据中台总体架构方案(PPT)

⊕ 92页PPT全方位解析:制造业到底需要什么样的互联网思维?

⊕ 关于数据中台的争议!10页PPT即可阐析

⊕ 前华为高管透析华为灰度管理|读书笔记(134页PPT)

⊕ 工程院院士解析|智慧城市数字孪生重构方案(PPT)

⊕【Insight】让人震惊的大数据全球市场(附36页PPT)

⊕【Insight】老业务要转型,新业务如何孵化?

【球迷Long笔记】Insight丨人生丨足球丨商业丨深度